Prompt Engineering: dlaczego wszyscy o tym mówią, ale niewielu wie, jak to robić?

Ostatnio trudno uciec od rozmów o prompt engineeringu. LinkedIn pęka od „specjalistów”, kursy online obiecują złote góry, a firmy szukają ludzi, którzy „umieją gadać z AI”. Ale czy za całym tym szumem coś stoi, czy to kolejna popularna umiejętność, która za chwilę zniknie?

Współpracując z klientami, widzę, że wielu z nich próbuje nadążyć za trendem AI. Problem jednak nie tkwi w narzędziach czy budżecie, ale w braku zrozumienia, czym naprawdę jest prompt engineering i jak rozmawiać z modelami językowymi, żeby uzyskać to, czego potrzebujemy.

Co to jest prompt engineering i dlaczego to realna umiejętność?

Prompt engineering to sztuka formułowania instrukcji dla modeli sztucznej inteligencji w sposób, który pozwala uzyskać pożądane rezultaty. Brzmi prosto? A ja powiem – nic bardziej mylnego.

Różnica między zwykłym „gadaniem z ChatGPT” a rzeczywistym prompt engineeringiem jest taka sama, jak między przypadkowym klikaniem w Google Ads a przemyślaną kampanią reklamową. W obu przypadkach używasz tych samych narzędzi, ale wyniki są diametralnie różne.

Kiedy klient mówi mi „sprawdzałem ChatGPT, ale efekty są słabe”, zazwyczaj oznacza to, że traktuje AI jak Google – wpisuje pytanie i spodziewa się natychmiastowej, idealnej odpowiedzi. To tak nie działa.

Prawdziwy prompt engineering wymaga zrozumienia, jak myślą duże modele językowe. One nie „myślą” jak człowiek – przetwarzają wzorce w tekście i generują prawdopodobne kontynuacje. Znajomość tej różnicy to podstawa skutecznego promptowania.

W praktyce oznacza to między innymi:

- instrukcję z jasną strukturą, nie luźną prośbę,

- pełen kontekst, zamiast zakładania, że AI wie, o co chodzi,

- iteracyjny proces, oparty na testach i optymalizacji.

Trzy poziomy prompt engineeringu – od podstawowego do zaawansowanego

Nie wszyscy potrzebują być ekspertami. W zależności od celów możesz operować na jednym z trzech poziomów.

Zero-shot prompting: poziom basic

To najprostszy poziom – dajesz AI jedno, jasne polecenie bez dodatkowych przykładów. Działa dobrze dla standardowych zadań.

Przykład słaby: „Napisz post na Linkedin”

Przykład lepszy: „Napisz post na LinkedIn o długości 150 słów dla CEO firmy technologicznej, który chce podzielić się spostrzeżeniami na temat zarządzania zespołem zdalnym. Ton profesjonalny, ale ciepły”.

Few-shot prompting: nauka na przykładach

Podajesz AI kilka przykładów tego, czego oczekujesz. Znacznie zwiększa jakość wyników dla bardziej specjalistycznych zadań.

Zamiast opisywać, jak ma wyglądać email, pokazujesz 2-3 przykłady dobrych e-maili i AI „łapie” wzorzec.

Chain-of-thought: skomplikowane rozumowanie

Najbardziej zaawansowany poziom – uczysz AI „myślenia krok po kroku”. Niezbędne dla złożonych analiz czy strategicznych wniosków.

Zamiast prosić o „analizę konkurencji”, prowadzisz AI przez kolejne etapy: identyfikacja konkurentów → analiza ich mocnych stron → porównanie z naszą ofertą → wnioski i rekomendacje.

Niestety – najczęściej widzę, jak firmy próbują używać zero-shot do zadań wymagających few-shot lub chain-of-thought.

Pięć błędów, które popełnia 90% osób zaczynających z prompt engineering

Przez ostatnie dwa lata cały czas spotykam się z tymi samymi błędami popełnianymi przez użytkowników AI. Wydawać by się mogło, że na każdym kroku mówi się i edukuje o tym, jak poprawnie promptować, jednak nie zawsze przynosi to realne skutki. Chyba mamy zbyt wysokie oczekiwania wobec AI.

Błędy, z którymi walczę na co dzień:

1. Za ogólne instrukcje

Błąd: „Przeanalizuj nasz rynek”

Lepiej: „Przeanalizuj rynek oprogramowania CRM w Polsce pod kątem: wielkości rynku, głównych graczy, trendów cenowych, barier wejścia dla nowych firm. Skup się na segmencie małych i średnich przedsiębiorstw”.

Dobra instrukcja zawiera informacje:

- co ma być zrobione,

- dla kogo / w jakim kontekście,

- na czym się skupić,

- jakiej formy oczekujesz (lista, analiza, porównanie itd.).

2. Brak kontekstu

AI nie zna Twojej firmy, branży czy celów. Każdy prompt powinien zawierać niezbędne informacje kontekstowe. To jak prosić obcą osobę o radę bez wyjaśnienia sytuacji.

Błąd: Zrób plan postów na styczeń dla biura nieruchomości.

Lepiej: Zrób plan postów na styczeń dla biura nieruchomości z Warszawy. Odbiorcy to ludzie 25-45 lat, którzy szukają pierwszego mieszkania. 40% postów ma uczyć, 30% pokazywać co się dzieje na rynku, 20% historie klientów. Pamiętaj, że w zimie mniej się kupuje mieszkania.

3. Ignorowanie ograniczeń modelu

Każdy model ma swoje mocne i słabe strony. Nie próbuj używać młotka do wkręcania śrub.

Jednym z najczęstszych błędów jest używanie modelu reasoningowego (np. GPT o3, o4-mini czy Gemini 2.5 Pro) do zadań typowo tekstowych. Z jakiegoś powodu wielu osobom wydaje się, że skoro model potrafi „myśleć” to automatycznie „wymyśli” lepsze teksty.

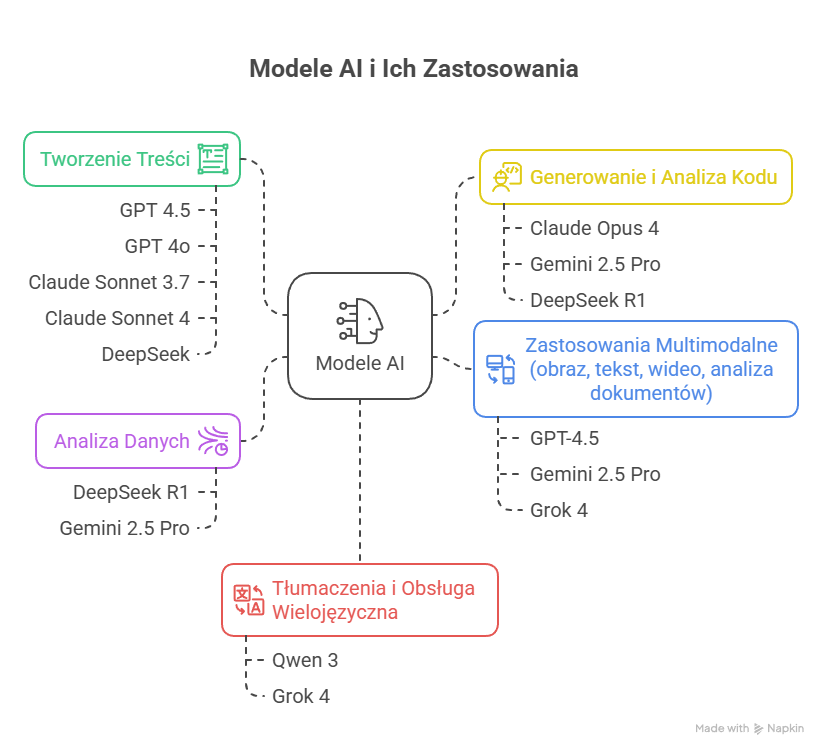

Modele reasoningowe są projektowane z myślą o analizie, rozumowaniu, planowaniu krok po kroku. Ich architektura jest zoptymalizowana do pracy złożonej intelektualnie, nie do generowania ładnych akapitów. Dlatego treści, które generują, bywają sztywne, mało naturalne i pozbawione lekkości.

Jeśli chcesz szybko i sprawnie tworzyć dobre teksty, lepszym wyborem będzie GPT 4o lub Claude Sonet 3.7. Są tańsze, szybsze i bardziej „literackie” w stylu.

4. Przekładanie ludzkiej logiki na AI

Ludzie myślą skojarzeniowo, AI przetwarza wzorce statystyczne. To, co jest oczywiste dla Ciebie, może być niezrozumiałe dla AI.

Błąd: „Napisz maila, który przekona do kupna” (AI nie wie, co ma przekonywać).

Lepiej: „Napisz maila o trzech problemach klientów: tracą czas na robienie raportów ręcznie, robią błędy w danych, ciężko im powiększyć zespół. Do każdego problemu dodaj, jak nasze narzędzie to rozwiązuje”.

5. Brak iteracji i testowania

Pierwszy prompt rzadko bywa tym najlepszym. A jednak wiele osób wpisuje jedno polecenie, dostaje średni wynik i uznaje, że „AI nie działa”. To trochę tak, jakby projektować kampanię reklamową, opierając się na jednym nagłówku i jednej grafice – bez A/B testów, bez optymalizacji, bez wniosków.

Skuteczny prompt engineering to proces iteracyjny. Piszesz → testujesz → poprawiasz. Czasem wystarczy doprecyzować jedno słowo, dodać przykład albo zmienić strukturę polecenia – i jakość odpowiedzi rośnie kilkukrotnie.

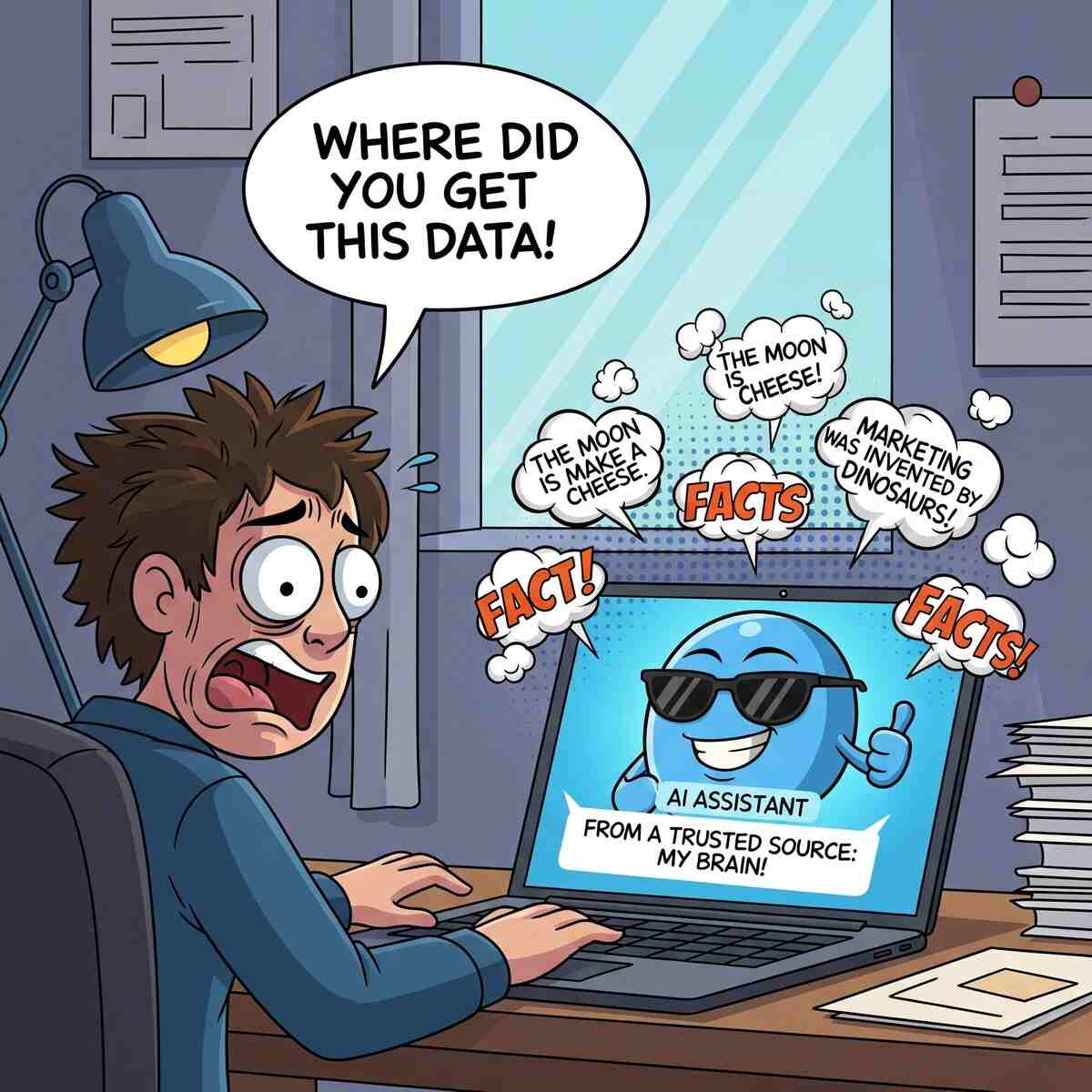

6. Ufanie AI „na słowo”

Modele językowe brzmią pewnie, nawet wtedy, gdy zmyślają i to jest właśnie to słynne halucynowanie. Może to doprowadzić do poważnych błędów, zwłaszcza gdy pozwalamy AI generować treści, które mają opierać się na faktach: artykuły, opisy produktów, porównania ofert, cytaty, dane.

Największy problem? Model nie wie, że kłamie. On po prostu przewiduje słowa, które pasują do kontekstu, a nie sprawdza ich prawdziwości.

Jeśli zależy Ci na jakości i zgodności z rzeczywistością, nie licz na to, że „AI samo wie”. Zadbaj o źródła:

- podaj w promptach fakty, które mają zostać użyte (np. wyniki badań, linki, dane z CRM-u, wcześniej przeprowadzony deep reaserch na temat danego zagadnienia),

- korzystaj z funkcji „Retrieval” (czyli podpiętych dokumentów lub baz wiedzy), jeśli Twój system na to pozwala,

- traktuj AI jak juniora: może napisać świetny draft, ale to Ty musisz go sprawdzić.

Halucynacje AI

Nie musisz być prompt ninja

Jeśli masz poczucie, że piszesz i testujesz, ale efekty wciąż są „takie sobie”, to nie znaczy, że AI się nie nadaje. Może po prostu trzeba inaczej je zapytać.

Coraz więcej marketingowców sprzedaje „gotowe prompty, które robią cuda”. Problem w tym, że cudów nie ma – jest kontekst, cel i konkretny sposób pracy. A to, co działa u jednej firmy, u drugiej może nie zadziałać wcale.

Z odrobiną wsparcia każdy może nauczyć się pisać skuteczne prompty samodzielnie. Pomagamy firmom tworzyć prompty, które działają. Zamiast tracić czas na zgadywanie, odezwij się. Zobaczymy, co da się wyciągnąć z Twojego AI.